Hohe Datenqualität ist in der heutigen datengetriebenen Welt von zentraler Bedeutung. In diesem Blog beleuchten wir die fünf Schritte zur Verbesserung der Datenqualität.

Hohe Datenqualität ist in der heutigen datengetriebenen Welt von zentraler Bedeutung. In diesem Blog beleuchten wir die fünf Schritte zur Verbesserung der Datenqualität.

Mit Datenmanagement zu einer hohen Datenqualität

Eine gute Datenqualität ermöglicht es Unternehmen ihre Kunden und deren Wünsche besser zu verstehen, ihre Prozesse schlank zu halten und digitale Produkte in kurzer Zeit marktfertig zu entwickeln. Des Weiteren stellen Daten in hoher Qualität die Grundvoraussetzung für Data-Exports und fortgeschrittenen Reporting-Anforderungen wie z.B. dem 2024 in Kraft tretende ESG-Reporting. Da diese Reports auf weit über 1000 Datenpunkte im Unternehmen zurückgreifen, müssen die zu Grunde liegenden Daten in hoher Qualität vorliegen um ein stressfreies & prüfsicheres Reporting gewährleisten.

Doch wie können Unternehmen ihre Datenqualität messen und sicherstellen, dass sie langfristig hochgehalten wird? In erster Linie sollte das Datenmanagement nicht isoliert betrachtet werden, sondern als ein vielschichtiges Framework, das auf allen Organisationsebenen integriert werden muss. Auf strategischer Ebene ermöglicht das Datenmanagement den Unternehmen, ihre Daten smart zu verwalten und ihr Potenzial zur Wertschöpfung voll auszuschöpfen. Auf der operativen Ebene unterstützt das Datenmanagement Unternehmen im Tagesgeschäft dabei, ihre Daten nutzbar zu machen. Zusammenfassend lässt sich sagen, dass Datenmanagement die strategische Kontrolle von Daten, die Organisation von Prozessen und Ressourcen zur Sicherstellung einer hohen Datenqualität, den Einsatz von Technologien zur Erfassung, Speicherung und Analyse von Unternehmensdaten sowie die verschiedenen Anwendungsfälle, in denen eine hohe Datenqualität einen geschäftlichen Mehrwert schaffen soll, vereint.

4 Dimensionen des Datenmanagements

“Data Excellence“ beschreibt die Fähigkeit das Potenzial der Daten voll auszuschöpfen. Sie bedarf den Aufbau von dedizierten Datenmanagement Fähigkeiten in 4 Dimensionen.

Die 4 Dimensionen des Datenmanagement

- Strategy: Das Datenmanagement legt die Daten-Vision, -Mission und -Ziele im Einklang mit den Unternehmenszielen fest und verfolgt deren Umsetzung im Zuge der Implementierung einer definierten Datenmanagement Roadmap.

- Business: Das Datenmanagement identifiziert aktuelle und zukünftige Business Use Cases, die durch Daten ermöglicht werden und unterstützt deren Umsetzung auf der Grundlage eines gemeinsamen Datenverständnisses der Business Daten.

- Technologie: Das Datenmanagement stellt die technische Systemarchitektur und Tool-Unterstützung bereit, um die Umsetzung von Business Use Cases und Data Governance effektiv zu unterstützen.

- Governance: Das Datenmanagement baut eine effektive Data Governance und Datenorganisation auf, die die Datenqualität optimiert und die richtigen Kompetenzen für eine effektive Datennutzung bereitstellt.

neoverv Data Quality Management Ansatz

Der Aufbau eines Data Quality Managements erfordert ein strukturiertes Vorgehen. Wir verstehen das Aufrechterhalten einer hohen Datenqualität als einen sich wiederholenden und flexibel anpassbaren Prozess – in Abhängigkeit von Ihrem Geschäftsgeschehen und Ausgangspunkt Ihres Datenqualitätsmanagements.

5 Schritte des Data Quality Managements

Unser Ansatz umfasst 5 Schritte, mit denen die Datenqualität messbar gemacht wird und nachhaltig verbessert und getrackt werden kann. Im Folgenden befassen wir uns mit den 5 Schritten und beschreiben im Detail welchen Einfluss und Vorteile es für ein gutes Datenmanagement hat.

Wie man die Datenqualität verbessert – in 5 Schritten zu einer hohen Datenqualität

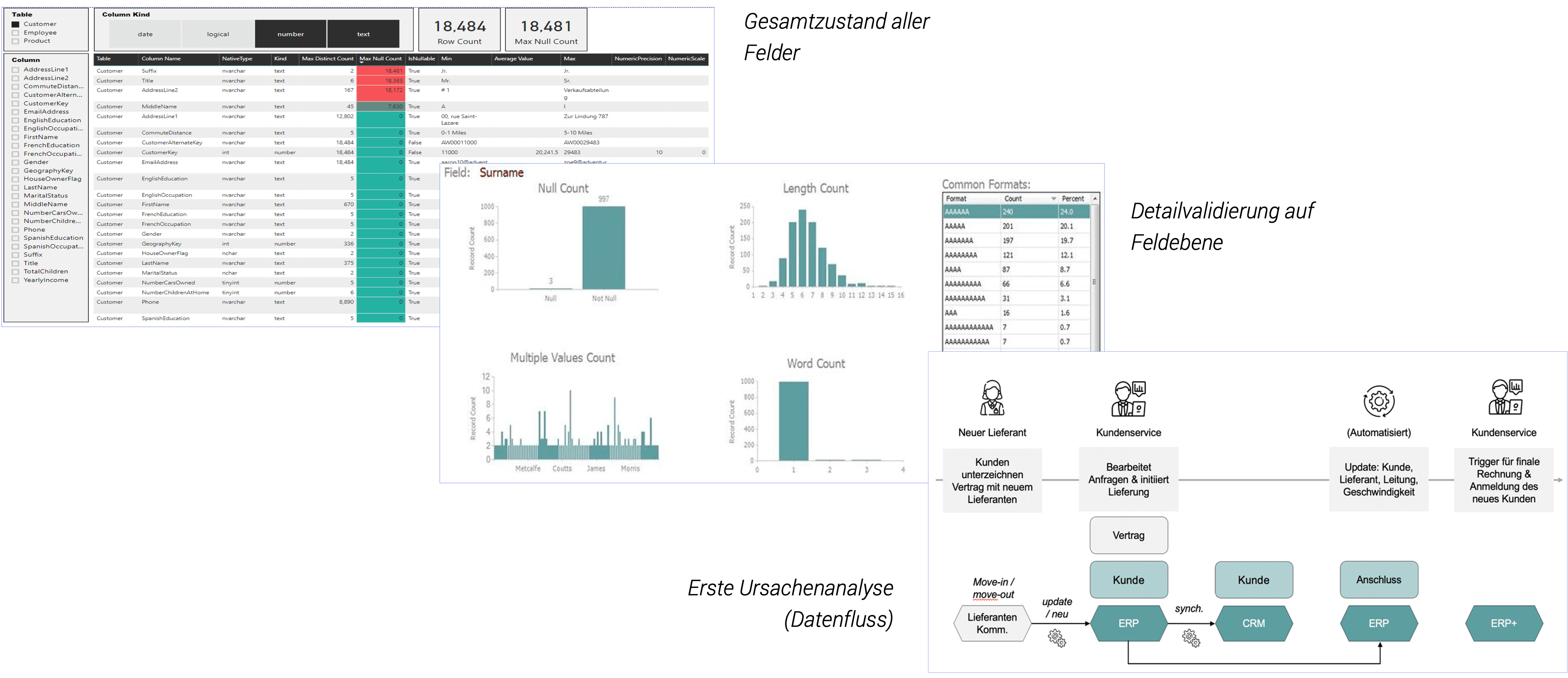

1. Data Profiling

Ein Data Profiling liefert den Gesamtzustand der Daten in einen bestimmten Datenbereich und setzt den Fokus für weitere Verbesserungen. Als ersten Schritt entlang der unseres Datenqualität Ansatz bildet es die Grundlage für die Messung der Datenqualität, datengetriebene Entscheidungsfindung und Qualitätsverbesserungen im gesamten Unternehmen oder dem ausgewählten Datenbereich. Im Rahmen des Data Profiling erfolgt eine tiefgreifende Analyse von Daten, um ihre Struktur, Qualität und Eigenschaften besser zu verstehen. Dabei werden Muster, Verteilungen und Metadaten der IT-Systemen untersucht, um ein klares Bild der vorliegenden Daten zu erhalten.

In den meisten Fällen beginnt man mit dem Auslesen der Haupt-Datenquelle z.B. ein ERP-System von SAP. Je nach Größe zieht man einen ausgewählten Datensatz oder einen Auszug aller sich im System befindenden Daten. Anschließend wird jede Spalte der bereitgestellten Daten untersucht und dabei Faktoren wie z.B. Häufigkeit, Verteilung (absolut & prozentual), Sonderzeichen oder auch Null-Werte analysiert.

Im Anschluss können auffällige Spalten bzw. Felder bei Auffälligkeiten im Detail betrachtet und erste Erkenntnisse abgelesen werden. Zusätzlich empfiehlt es sich an dieser Stelle sich die vor- & nachgelagerten Datenflüsse anzuschauen und gegebenenfalls zu visualisieren. Die Visualisierung unterstützt eine erste Ursachenanalyse und kann Indikationen geben, an welcher Stelle die Datenqualität beeinträchtigt werden könnte. Die gesammelten Erkenntnisse bilden die Grundlage für die anschließende Datenbereinigung – das Data Cleansing.

Auswahl von Data Profiling Ergebnisse (beispielhaft)

2. Data Cleansing

Beim Data Cleansing, auch Datenbereinigung genannt, werden die zuvor identifizierten Auffälligkeiten behoben und die Daten einmalig bereinigt („get clean“).

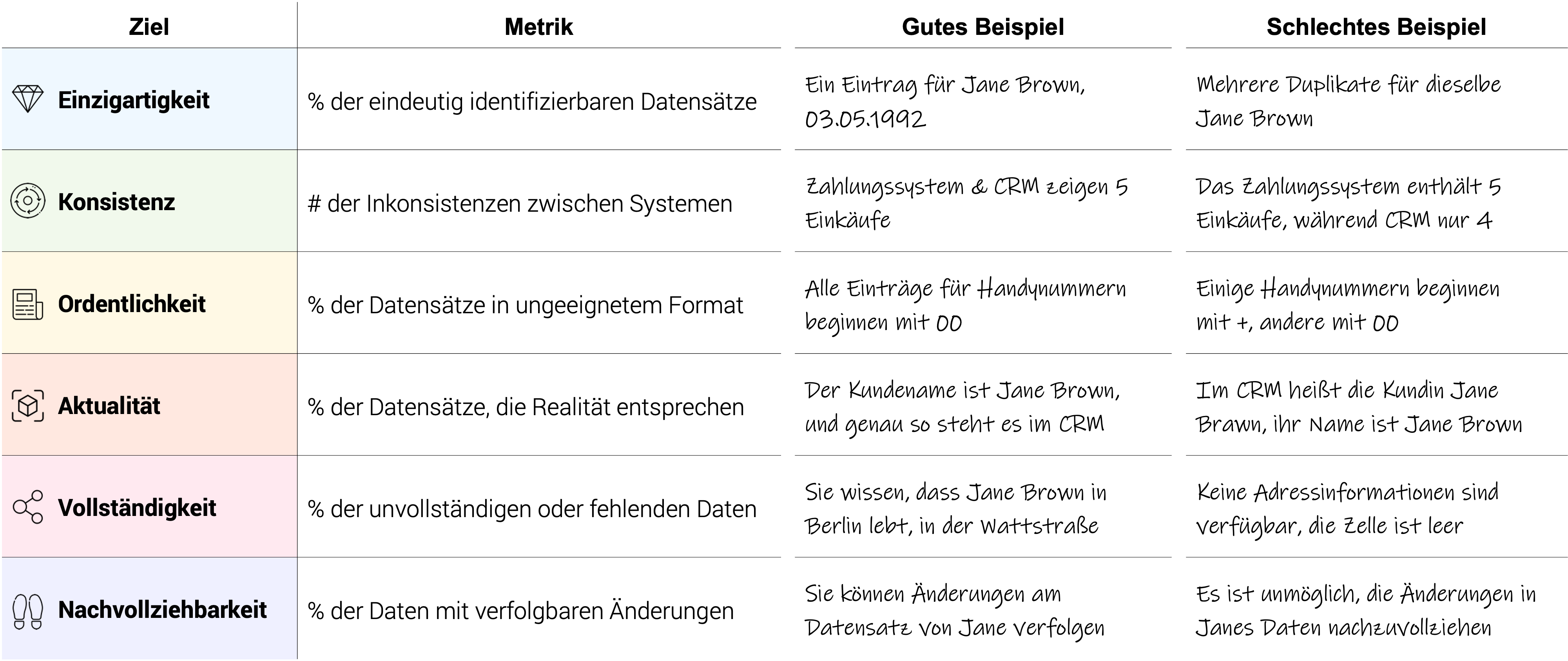

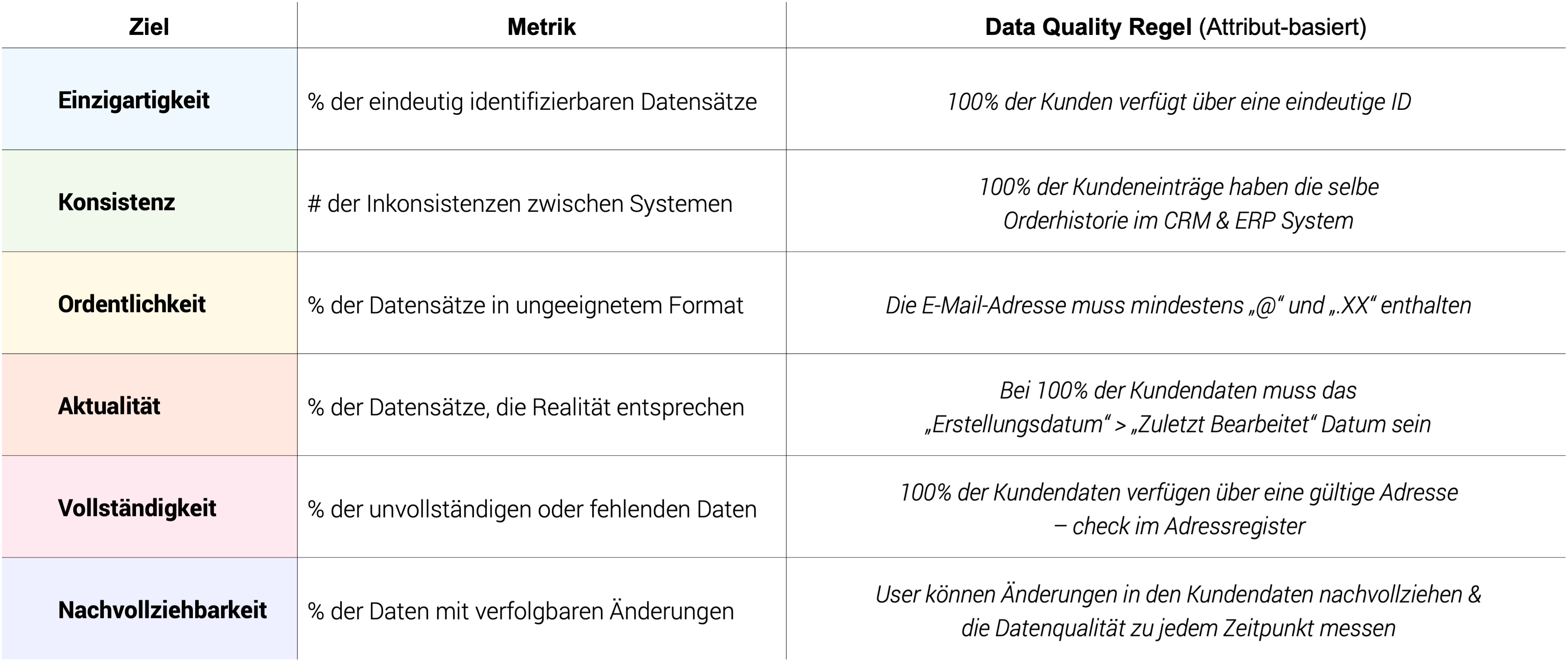

Doch wo beginnt man hier und wo hört man auf? Um zu vermeiden, dass man sich zu viel vornimmt und so gegebenenfalls die Qualität der Resultate beeinträchtigt, ist es wichtig klare Ziele in der Datenqualität zu verfolgen, die mit Hilfe konkreter Maßnahmen erreicht werden. Die Datenqualität Ziele sollten gemäß ihrem Geschäftswert priorisiert und mit den Unternehmenszielen verbunden werden. Im Grunde lassen sich die Ziele in sechs Bereiche einteilen (siehe Abbildung unterhalb):

Welche Datenqualitätsziele gilt es zu beachten?

- Einzigartigkeit: Jeder Datensatz muss eindeutig identifizierbar sein. Duplikate können leicht zu fehlerhaften Analysen oder Entscheidungen führen wie z.B. nicht korrekt zustellbare Rechnungen.

- Konsistenz: Die Datensätze müssen widerspruchsfrei sein, sowohl innerhalb einer einzelnen Datenquelle als auch zwischen verschiedenen Datenquellen. Inkonsistente Daten können zu Verwirrung und Unstimmigkeiten führen.

- Ordentlichkeit: Die jeweiligen Datensätze sollten alle in einem standardisierten Format gespeichert werden. Unstimmigkeiten wie z.B. falsche Vorwahlformate oder E-Mail-Adressen erschweren den Kundenkontakt.

- Aktualität: Die Datensätze sollen stets den neuesten Stand wiedergeben und aktuelle Informationen widerspiegeln. Veraltete Datensätze sollten regelmäßig bereinigt und ggf. aktualisiert werden.

- Vollständigkeit: Die Daten sollten alle relevanten Informationen enthalten und keine Lücken aufweisen. Unvollständige Datensätze führen verzerrten Ergebnissen und unvollständigen Einblicken.

- Nachvollziehbarkeit: Es muss in den Datensätzen stets nachvollziehbar sein, welche Änderungen zu welchem Zeitpunkt stattgefunden haben.

Auswahl Datenqualitätsziele inkl. Beispielen

3. Data Understanding

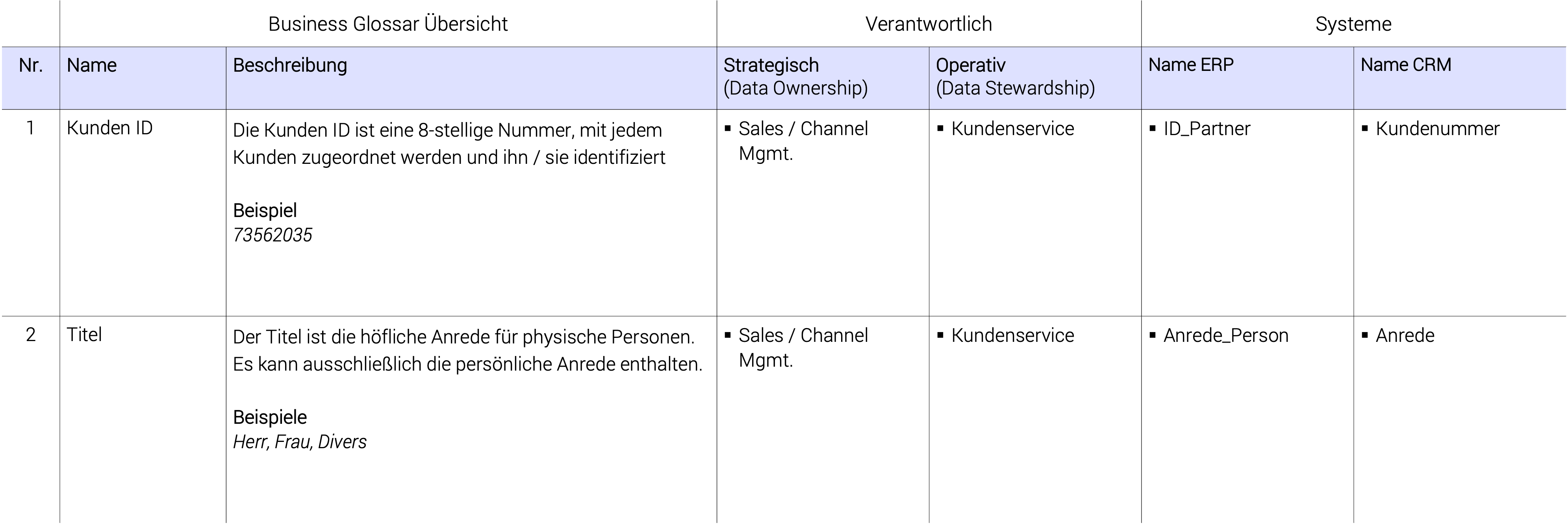

Im Anschluss an die Bereinigung der Datensets („get clean“), sollten Maßnahmen eingeleitet werden, die dafür sorgen, dass die Datenqualität nachhaltig hochgehalten wird („stay clean“). Als Startpunkt eignet es sich zu überprüfen, ob alle Bereiche, die die Daten verwalten und verarbeiten eine gleiche Auffassung von den Geschäftsbegriffen und deren Bedeutung haben.

Ein gemeinsames Datenverständnis (Data Understanding) ist an dieser Stelle unerlässlich. In vielen Unternehmen herrscht heute noch kein einheitliches Verständnis, wenn es um wichtige Geschäftsbegriffe bzw. Datenobjekte geht. Ein typisches Beispiel sind die Kundendaten. Während das Marketing den Begriff „Kunde“ als Einzelperson interpretiert, versteht das Controlling darunter ggf. auch andere Unternehmen oder Geschäftspartner.

Zur Entwicklung und zum Festhalten der gemeinsam festgelegten Definitionen eignet sich die Verwendung eines Business Glossars. Ein Business Glossars kann die Informationsqualität steigern und dabei unterstützen, dass alle Bereiche im Unternehmen verstehen, was unter dem Begriff „Kunde“ gemeint ist – und was nicht. Zum Start eignet sich hier bereits eine leichtgewichtige Excel-Lösung.

Lesen Sie hier, wie Sie ihr eigenes Business Glossar erstellen und ein gemeinsames Datenverständnis ermöglichen.

Beispieleintrag eines Business Glossars

4. Data Standardization

Im Data Cleansing wurden bereits die ersten Datensets erfolgreich bereinigt und im anschließenden Data Understanding das gemeinsame Verständnis geschaffen, mit dem man auf die Daten blickt. Die Data Standardization umfasst die Umsetzung und Implementierung zuvor gemeinsam festgelegter Daten-Standards und Datenqualitätsregeln. Mit Hilfe der Data Standardization wird dafür gesorgt, dass die Daten nachhaltig in hoher Qualität bleiben („stay clean“). Die Datenverantwortlichen (Data Owner und Data Stewards) entwickeln gemeinsam mit den wichtigsten Stakeholder die Regeln zur Datenqualität, mit denen die Daten nachhaltig sauber bleiben und beispielsweise Auffälligkeiten, wie im Data Profiling festgestellt sich nicht wiederholen können. Die Ausarbeitung der Regeln sollte dabei einer klaren Struktur folgen. Hier eignet es sich sehr gut, die im Data Cleansing aufgestellten Ziele zur Grundlage zu nehmen und die Datenqualitätsregeln an den dort aufgestellten Metriken zur Datenqualität ausrichten und Umsetzungsmaßnahmen zu beschließen.

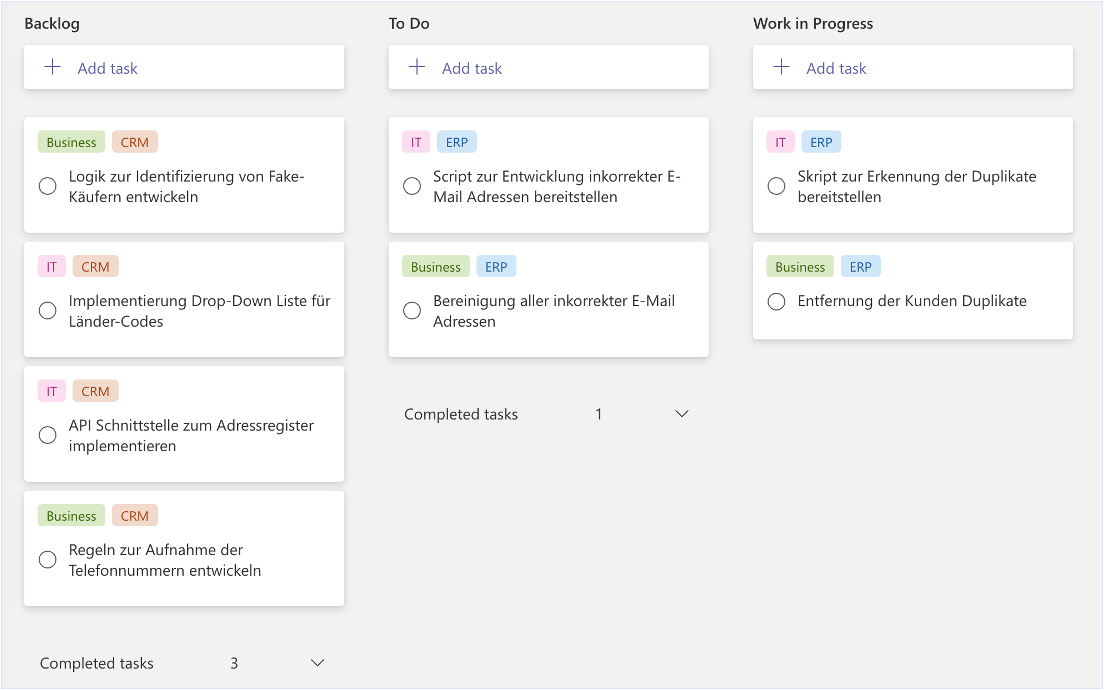

Da die Umsetzung von solchen Maßnahmen, gerade, wenn sie nicht nur Business-Bereiche betreffen, sondern auch IT-Unterstützung bedarf, empfiehlt es sich die Maßnahmen zu gemeinsam priorisieren und mit Hilfe agiler Methoden (z.B. Scrum oder Kanban) in kleinere Unteraufgaben zu einzuteilen und mit den Aufgaben aus dem Tagesgeschäft zu verknüpfen.

Auswahl von Datenqualitätsregeln (beispielhaft)

Die Abbildung unterhalb zeigt an Beispielen, wie die Verknüpfung von Datenqualitätsregeln und Zielen erfolgen kann und wie die festgelegten Maßnahmen agil umgesetzt werden können.

Beispiel einer agilen Umsetzung von Maßnahmen für eine gute Datenqualität

5. Data Monitoring

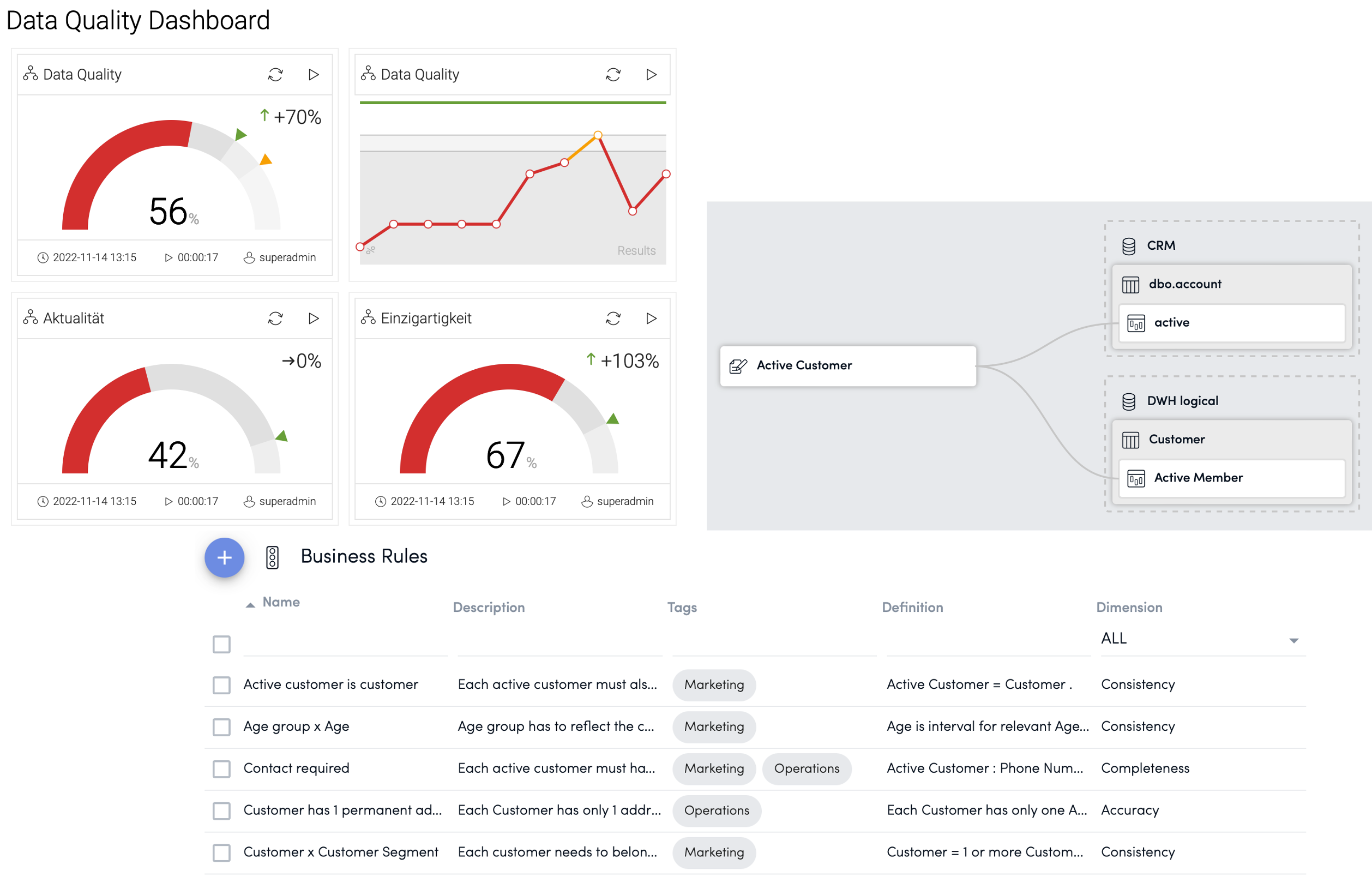

Das Data Monitoring beschreibt formal den letzten Schritt des Datenqualität Managements, jedoch begleitet das Monitoring jeden die zuvor beschriebenen Schritte. Im Data Monitoring wird der Zustand der Daten getrackt und nachvollziehbar dokumentiert. Den Anwendern ist es so möglich, den Erfolg der Datenqualität-Maßnahmen messbar nachzuvollziehen und gegebenenfalls anzupassen.

Für das Data Monitoring eignet sich es gut Datenqualität Tools zur Hilfe zu nehmen. Moderne Datenqualität-Tools können per APIs bequem an die Quellsysteme angebunden und ausgelesen werden. Mit Hilfe dieser Tools sind die Anwender so in der Lage ein Live-Zustand der Datenqualität zu geben. Mit Hilfe praktischer Dashboards lassen sich Maßnahmen verfolgen und direkt Reports erstellen, falls akute Maßnahmen in den Datensätzen erforderlich sind.

Data Quality Tools haben in der Regel nur lesenden Zugriff, sodass keine unerwarteten Änderungen an den Daten möglich sind. Fortgeschrittene bzw. Enterprise-Lösungen bieten zudem auch schreibenden Zugriff, mit Hilfe wessen sich die Datenqualität direkt aus dem Tool Ende-zu-Ende verwalten und sich eine Datenintelligenz etablieren lässt.

Ausgewählte Ansichten eines Data Quality Tools

Wie gelingt der Start?

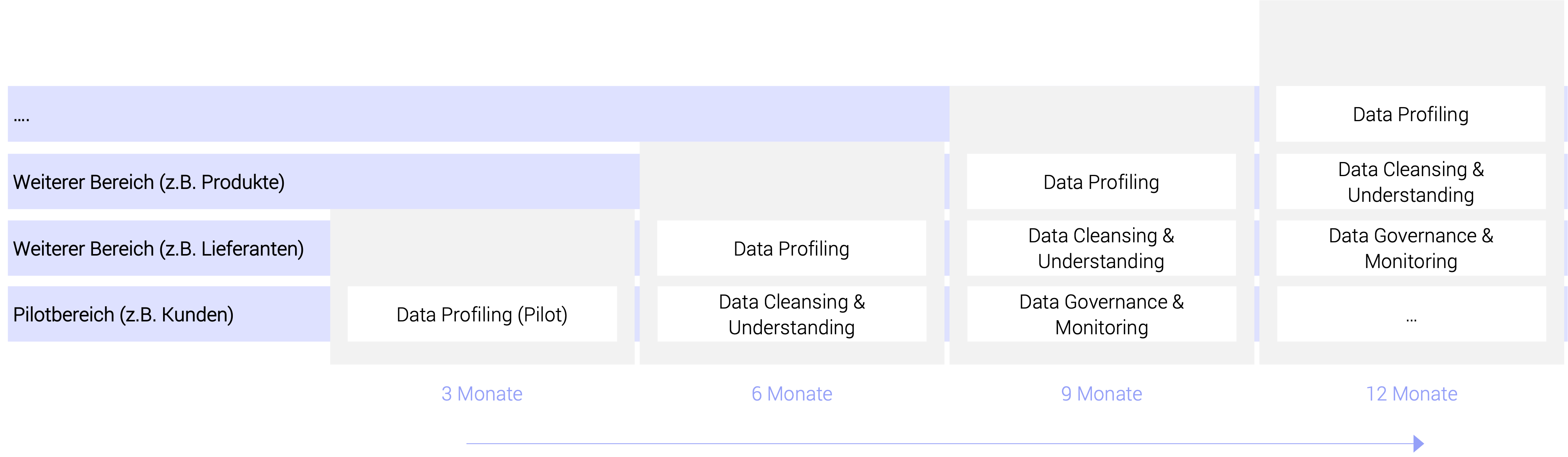

Der Start ins Data Quality Management sollte problemlos in das Tagesgeschäft zu integrieren sein. Wir empfehlen zum Start in einem Pilotbereich auszuwählen, in dem sich für das Geschäft wichtige Daten befinden (z.B. Kundendaten).

An ihnen lassen sich die erzielten Erfolge am besten bewerten, da sie den größten Geschäftswert beinhalten. Sukzessive kann man anschließend das Data Quality Management in weitere Bereiche ausrollen und das Erlernte aus den bereits abgeschlossenen Schritten anwenden.

Mögliches Umsetzungsvorgehen für ein Data Quality Management

Fazit

Die Gewährleistung von Datenqualität ist in der heutigen datengetriebenen Welt von entscheidender Bedeutung. Unternehmen stehen vor der Herausforderung, immer größere Mengen an Daten zu erfassen, zu speichern und zu analysieren. Ohne ein solides Datenmanagement können diese Daten jedoch wertlos sein und das volle Potenzial nicht ausgeschöpft werden. In diesem Blog haben wir die unsere fünf Schritte des Datenqualitätsmanagement beleuchtet und wie sie zur Verbesserung der Datenqualität beitragen.

Zusammenfassend ist das Data Quality Management ein fortlaufender Prozess, der die Zusammenarbeit zwischen verschiedenen Abteilungen und die Nutzung von Technologie erfordert. Es ist keine einmalige Aufgabe, sondern eine Investition in die Genauigkeit und Zuverlässigkeit Ihrer Datenqualität, die sich langfristig auf Ihren Unternehmenserfolg auszahlt.

Sie möchten Ihre Datenqualität messbar machen und verbessern?

Lesen Sie in unserem Data Strategy Playbook mehr zum Thema wie Sie im Rahmen des Datenmanagement Ihr Data Quality Management aufbauen und Ihre Datenstrategie mit Erfolg umsetzen können.

Das Playbook zeigt:

- Vorteile eines Datenmanagements

- Notwendige Fähigkeiten in den Datenmanagement

- Dimensionen Strategie, Business, Daten Governance und Technologie

- Wie Unternehmen diese Fähigkeiten in einem schrittweisen Vorgehen aufbauen können

Haben Sie weitere Fragen? Sprechen Sie mich gerne an oder vereinbaren Sie ein kostenloses Beratungsgespräch.

Unsere Datenmanagement Services

- Umfassendes Data-Assessment

- Datenstrategie festlegen

- Daten „Use Cases“ identifizieren

- Datenqualität messen und verbessern

- Effektive Data Governance etablieren

- Datenarchitekturen aufsetzen

Mehr erfahren

Mehr erfahren

Bei neoverv helfen wir Unternehmen Innovations- und Nachhaltigkeitsherausforderungen mit Technologie zu lösen. Sprechen Sie mich an, um zu erfahren wie wir Sie unterstützen können.